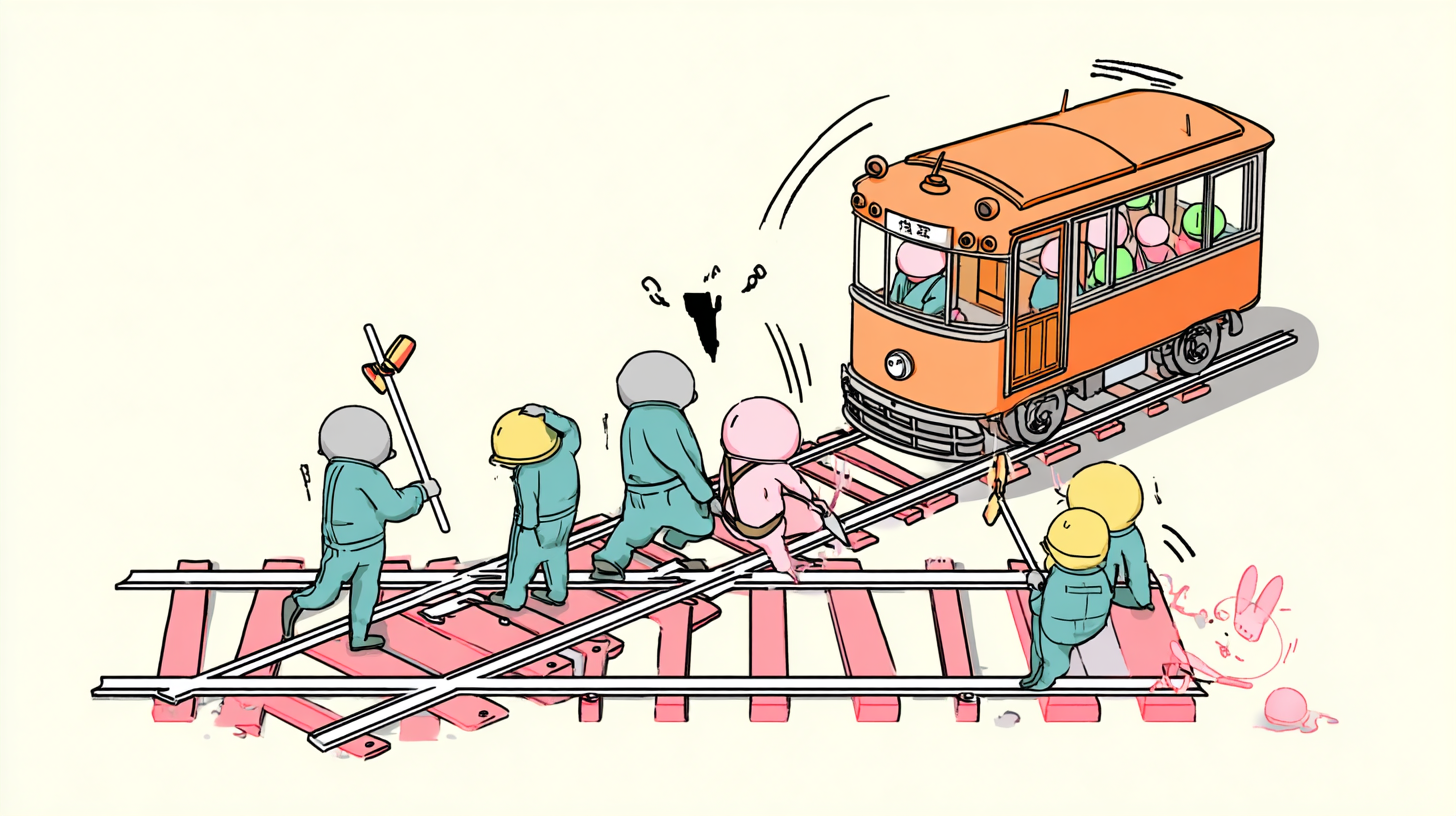

「5人を救うために1人を犠牲にしてもよいか?」この究極の選択を、AIはどう考えるのでしょうか。有名な倫理問題をAIに投げかけてみた結果から、AI時代の道徳について考えてみましょう。

トロッコ問題って何?AIが悩む究極の選択

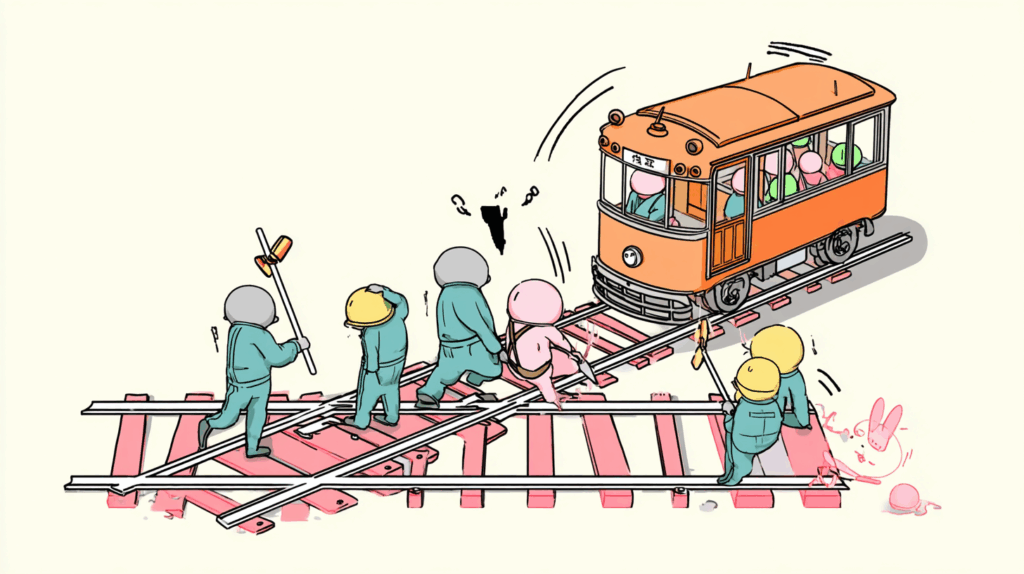

想像してください。

暴走する電車が5人の作業員に向かって走っています。あなたの目の前にはレバーがあり、引けば電車は別の線路に。でも、そこには1人の作業員が。

5人を救うために1人を犠牲にする?それとも何もしない?

これが「トロッコ問題」です。1967年にイギリスの哲学者が考えた問題で、今もなお正解がありません。

人間でも答えに困るこの問題。AIに聞いたら、どんな答えが返ってくるでしょうか?

ここがポイント: トロッコ問題は「多数を救うために少数を犠牲にできるか」を問う究極の倫理問題です

AIたちの答えを比べてみた

ChatGPT、Gemini、Grokという3つの代表的なAIに、同じ質問をしてみました。

ChatGPTは、こう答えました。「倫理的に考えると、可能な限り犠牲者を減らすことが望ましい」として、レバーを引く選択が合理的かもしれないと。でも同時に、「これは非常に難しい問題で、絶対的な正解はない」とも付け加えました。

Geminiは、より慎重でした。「どちらの選択も重大な結果を伴う」として、明確な答えを避けました。代わりに、さまざまな倫理学の立場(功利主義や義務論など)を説明してくれました。

Grokは、少し違う視点を提供しました。「現実世界では、もっと他の選択肢があるはず」と指摘。警笛を鳴らす、緊急停止を試みるなど、二者択一以外の可能性を探ることを提案しました。

興味深いことに、どのAIも「正解はない」という点では一致していました。

ここがポイント: AIたちも人間と同じように、この問題に明確な答えを出せませんでした

自動運転車が直面する現実のトロッコ問題

この問題、実は私たちの生活にとても身近になっています。

自動運転車を想像してください。突然、道路に5人が飛び出してきました。避けるには歩道の1人に向かうしかない。AIはどう判断すべきでしょうか?

2024年、国土交通省はトロッコ問題の解決を含む自動運転の法的要件整備に約2億4100万円の予算をつけました。これは、ラーメン約240万杯分の金額です。それだけ重要な問題なのです。

MITメディアラボの「モラル・マシン」という実験では、世界233か国から4000万件もの回答が集まりました。結果は国によって大きく違い、「子どもを優先する国」「お年寄りを大切にする国」などさまざまでした。

ここがポイント: 自動運転の時代、トロッコ問題は机上の空論ではなく現実の課題になっています

AIに倫理を教える3つの方法

では、AIにどうやって倫理的な判断をさせればよいのでしょうか?専門家たちは3つの方法を考えています。

1. ルールを決める方法

「絶対に人を傷つけてはいけない」など、明確なルールをプログラムする方法です。でも、トロッコ問題のような場合はどうすればいいのでしょう?

2. 結果で判断する方法

「犠牲者を最小限にする」という考え方です。5人より1人の方が被害が少ない、という計算です。でも、命に数の大小をつけていいのでしょうか?

3. 人間の判断を学ぶ方法

たくさんの人間の判断データを集めて、AIに学習させる方法です。でも、人間の判断も完璧ではありませんよね。

どの方法も一長一短があり、完璧な解決策はまだ見つかっていません。

ここがポイント: AIに倫理を教える完璧な方法はまだなく、研究が続いています

私たちがAIと向き合うために

トロッコ問題にAIが答えられないのは、実は良いことかもしれません。

なぜなら、これは「人間らしさ」の証明だから。悩み、迷い、完璧な答えを出せない。それが人間の特徴であり、AIもその人間らしさを受け継いでいるのです。

大切なのは、AIに全てを任せるのではなく、人間とAIが一緒に考えること。特に命に関わる判断は、最終的には人間が責任を持つべきでしょう。

2027年には日産が自動運転の乗り合いサービスを始める予定です。その時までに、私たち一人一人がこの問題について考えておく必要があります。

あなたなら、どちらを選びますか?そして、その選択をAIに任せられますか?

ここがポイント: AI時代だからこそ、人間の倫理観と責任がより重要になっています